Bài viết được ghim

Độ hot của Langchain

Langchain là một framework vô cùng hot hit trong thời gian gần đây. Nó được sinh ra để tận dụng sức mạnh của các mô hình ngôn ngữ lớn LLM như ChatGPT, LLaMA... để tạo ra các ứng dụng trong thực tế. Dù mới được phát triển cách đây khoảng 6 tháng (10/2022) và vẫn được cập nhật liên tục hàng ngày nhưng trên Github Langchain đã nhận được những tương tác khủng với lượng star lê...

Tất cả bài viết

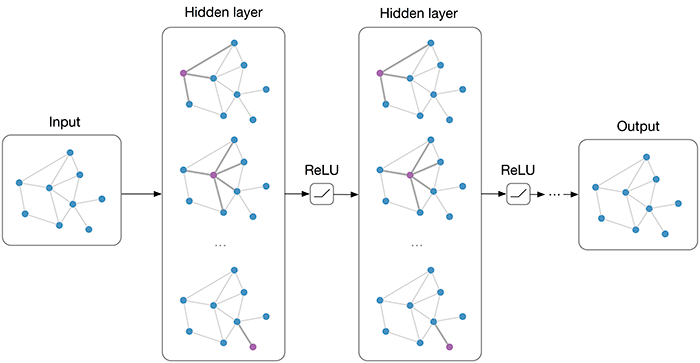

Trong thế giới phát triển ứng dụng sử dụng Mô hình Ngôn ngữ Lớn (LLM), việc xây dựng các tác vụ phức tạp như chatbot, hệ thống phân tích văn bản hay trợ lý ảo đòi hỏi sự kiểm soát chặt chẽ và khả năng mở rộng linh hoạt. LangGraph, một thư viện mã nguồn mở từ LangChain, ra đời để giải quyết những thách thức này bằng cách cung cấp một framework dựa trên đồ thị, cho phép mô hình hóa và quản lý các...

Mở đầu Tìm hiểu lý thuyết về Model Context Protocol (MCP), chắc hẳn các bạn sẽ gặp phải các keywords như Resources, Prompts, Tools, Sampling, Roots, Transports, ... Để có thể sử dụng MCP cho dự án của mình thì mình nghĩ càng cần thiết cho việc hiểu rõ các khái niệm này Không lòng vòng nữa, cùng trao đổi về các vấn đề này thôi. Gét gô

"Resources" - Nền tảng cung cấp ngữ cảnh đa dạng cho AI Reso...

Mở đầu. Halooo, được hơn tháng rồi mà chưa có idea gì mới để ngồi viết lách học một vài kiến thức mới (văn vở vậy thôi chứ thật ra do mình lười 🙂 và cũng bận bên dự án nữa), nên vẫn là nhân cơ hội nghỉ lễ và thời gian chill chill cuối tuần cũng như hưởng ứng mayfest nên là khả năng cao là trong tháng 5 này sẽ có một series nhỏ đâu đó có một vài bài gì đó nữa về Advanced LLM mình thấy hay chia s...

Mở đầu Trí tuệ nhân tạo (AI), đặc biệt là các mô hình ngôn ngữ lớn (LLMs), đã đạt được những bước tiến phi thường, mang đến khả năng trò chuyện, sáng tạo và giải quyết vấn đề ấn tượng. Tuy nhiên, khi chúng ta tương tác với AI trong các cuộc hội thoại kéo dài hoặc các tác vụ phức tạp gồm nhiều bước, một thách thức lớn thường xuất hiện: làm thế nào để AI "nhớ" được những gì đã xảy ra trước đó? Là...

Cho model thêm thời gian để "nghĩ" Hướng dẫn model tự tìm ra giải pháp trước khi vội vàng đưa ra kết luận

- Ý tưởng cốt lõi: Buộc mô hình phải thực hiện một quy trình suy luận từng bước một cách nội bộ trước khi đưa ra câu trả lời hoặc kết luận cuối cùng. Tránh việc mô hình "nhảy bổ" vào kết luận mà không cân nhắc kỹ lưỡng.

- Vấn đề giải quyết:

- Lỗi suy luận vội vàng: LLMs thường mắc lỗi k...

Mở đầu

Những hạn chế của tìm kiếm thuần túy dựa trên từ khóa (lexical search) ngày càng rõ ràng: bỏ lỡ các từ đồng nghĩa, không nắm bắt được các khái niệm liên quan, và khó khăn trong việc trả lời các câu hỏi phức tạp. Để giải quyết những thách thức này, Azure AI Search cung cấp các tính năng ranking nâng cao, đặc biệt là Semantic Ranking và khả năng kết hợp tìm kiếm đa phương thức thông qua H...

Mở đầu

Trong Phần 1, chúng ta đã cùng tìm hiểu về khái niệm cơ bản của scoring trong Azure AI Search và cách thuật toán mặc định BM25 xếp hạng các tài liệu dựa trên mức độ liên quan (relevance) với truy vấn tìm kiếm. Mặc dù BM25 hoạt động rất hiệu quả trong nhiều trường hợp, nhưng thực tế cho thấy, đôi khi chúng ta cần nhiều hơn thế. Có những lúc bạn muốn "ưu ái" những sản phẩm đang giảm giá, ...

[Paper Explain] A new direction in text generations. Let's deep into Large Language Diffusion Model.

Mở đầu. Halu, Xin chào mọi người, lâu quá rồi chưa quay trở lại viết 1 bài viết nào cả, nên là nhân cơ hội được nghỉ thư giãn 1 vài ngày cuối tuần ngồi đọc đọc xem có gì vui không 😁 thì có 1 paper khá hay vừa được public vào đầu năm, tên thì mọi người biết luôn rồi nhỉ LLaDA (Large Language Diffusion Model), paper này được đánh giá là một trong những hướng đi mới thú vị và đổi mới cách tư duy. ...

I. Giới thiệu

Các mô hình đa phương thức tiên tiến nhất hiện nay, có khả năng xử lý cả hình ảnh và văn bản, đã thể hiện những khả năng ấn tượng, chẳng hạn như tạo ra các mô tả hình ảnh chi tiết và trả lời chính xác các câu hỏi trực quan phức tạp. Các mô hình thị giác-ngôn ngữ (VLMs) này rất quan trọng cho sự tiến bộ của AI. Tuy nhiên, hầu hết các VLM có hiệu suất cao nhất vẫn là độc quyền, ngh...

Mở đầu. Xin chào mọi người đến với bài tiếp theo của practical Series. Nhân tiện bài trước đó của mình có điểm qua một số phương pháp Chunking (ở đây), tập trung hơn một chút về agentic chunking. Thì đến bài này chúng ta sẽ điểm qua 1 kỹ thuật khác là Late Chunking giúp cải thiện trong phase Chunking và Retrieval của RAG.

Important : Trước khi đọc bài viết, mình xin được nhắc lại, đây không ph...

Tổng quan Xin chào tất cả mọi người, RAG từ lâu đã trở thành một công nghệ quan trọng trong lĩnh vực AI, đặc biệt là trong việc tối ưu hóa cách chúng ta khai thác và sử dụng dữ liệu. Với sự kết hợp độc đáo giữa khả năng truy xuất thông tin chính xác (retrieval) và sức mạnh sáng tạo của các mô hình ngôn ngữ lớn (LLM), RAG đã chứng minh hiệu quả vượt trội trong việc giải quyết các bài toán phức t...

Self prompting

Trong quá trình ứng dụng các mô hình ngôn ngữ lớn (LLM), một vấn đề nổi bật là sự phụ thuộc vào prompt engineering – việc thiết kế các câu lệnh đầu vào để hướng dẫn mô hình. Tuy nhiên, việc này đòi hỏi nhiều thử nghiệm thủ công, tốn thời gian, và thường thiếu tính nhất quán, đặc biệt khi đối mặt với các tác vụ phức tạp hoặc các yêu cầu thay đổi theo ngữ cảnh. Hơn nữa, hiệu suất ...

- Giới thiệu chung Ngày nay việc sử dụng các mô hình ngôn ngữ lớn tiêu biểu như ChatGPT của OpenAI đã trở nên cực kì phổ biến. Thông thường mọi người chỉ dùng chức năng nhắn tin để hỏi đáp với các model như gpt3.5, gpt4o. Các mô hình này hoạt động rất tốt và phản hồi tương đối nhanh nếu xét trên phương diện nhắn tin, nhưng nếu chúng ta muốn việc tương tác trở nên thuận tiện hơn nữa bằng việc h...

I.Giới thiệu

Trong thời đại các mô hình ngôn ngữ lớn (LLM) và các API cho AI service phát triển mạnh mẽ, việc xây dựng các ứng dụng sử dụng chúng ngày càng phổ biến. Tuy nhiên, khi ứng dụng phải phục vụ số lượng lớn người dùng, việc xử lý đồng thời nhiều yêu cầu (request) trở thành một thách thức lớn. Các API thường có giới hạn tài nguyên và thời gian phản hồi, đòi hỏi lập trình viên không chỉ...

Chào mừng các bạn đã đến tới series một vài câu chuyện xung quanh phát triển Chabot. Trong series này gồm nhiễu bài viết mình dự định có cách nội dung như sau:

- Phần 1: Tổng quan về ChatBot và các phương pháp phát triển

- Phần 2: Mình tập tành xây dựng hệ thống ChatBot như nào và khái niệm các kĩ thuật liên quan

- Phần 3: Mình tập tành xây dựng hệ thống ChatBot như nào và khái niệm các kĩ thu...

Mở đầu. Trong lĩnh vực Hồi đáp theo Kiến thức (RAG), việc chia nhỏ văn bản (chunking) là một bước quan trọng để tối ưu hóa truy xuất và sử dụng thông tin. Các kỹ thuật chunking không chỉ cải thiện độ chính xác mà còn giúp tổ chức dữ liệu hiệu quả hơn cho mô hình ngôn ngữ lớn (LLMs). Bài viết này sẽ giới thiệu các loại chunking phổ biến, và chú ý hơn một chút về Semantic Chunking và Proposition...

Overview Trong bài viết lần trước, mình đã trình bày về tổng quan lý thuyết về Triton Inference Server bao gồm kiến trúc của Triton, các tính năng chính, thông tin cơ bản và một số Triton Server Tool. Ta hãy cùng sơ lược lại một chút thông tin.

Triton Inference Server là gì ? Triton Inference Server là một "open source inference serving software", cho phép deploy các AI model từ nhiều deep-mac...

Lời mở đầu

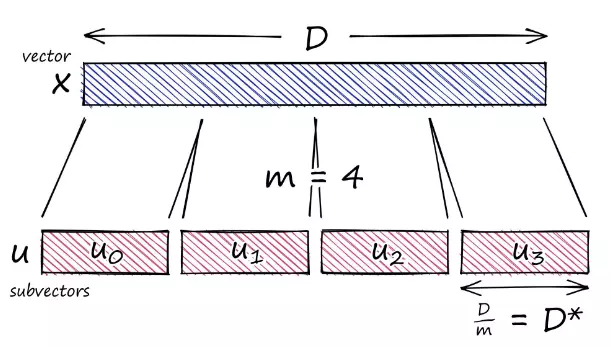

Các mô hình embedding văn bản hoạt động rất tốt ở việc encoding các đoạn văn bản (dữ liệu không có cấu trúc) và khiến cho việc tìm kiếm các văn bản giống nhau một các dễ dàng hơn. Và các mô hình embedding này đang được sử dụng phổ biến trong các kiến trúc RAG (Retrieval Augmented Generation) hiện nay, với khả năng có thể encode và truy hồi các thông tin liên quan từ tài liệu hoặc cá...

I. Giới thiệu Với sự phát triển nhanh chóng của trí tuệ nhân tạo trong những năm trở lại đây, các mô hình ngôn ngữ lớn (LLM) đang giải quyết nhiều bài toán đa dạng trong nhiều lĩnh vực:

- Trả lời câu hỏi tự nhiên và hỗ trợ khách hàng: LLM có thể xử lý các câu hỏi từ khách hàng, tự động cung cấp câu trả lời hoặc hướng dẫn người dùng qua chatbot, giúp tối ưu hoá trải nghiệm khách hàng.

- Hỗ trợ s...