Bài viết được ghim

Độ hot của Langchain

Langchain là một framework vô cùng hot hit trong thời gian gần đây. Nó được sinh ra để tận dụng sức mạnh của các mô hình ngôn ngữ lớn LLM như ChatGPT, LLaMA... để tạo ra các ứng dụng trong thực tế. Dù mới được phát triển cách đây khoảng 6 tháng (10/2022) và vẫn được cập nhật liên tục hàng ngày nhưng trên Github Langchain đã nhận được những tương tác khủng với lượng star lê...

Tất cả bài viết

- Giới Thiệu

Xin chào mọi người, lại là tôi đây. Trong bài viết này mình xin giới thiệu về Mem0, một phương pháp quản lý Long Term Memory trong hệ thống AI Agents. Bài này mình chủ yếu đọc từ paper và trình bày cấu trúc theo paper: Mem0

Mọi người có thể đọc paper gốc để nắm được chi tiết.

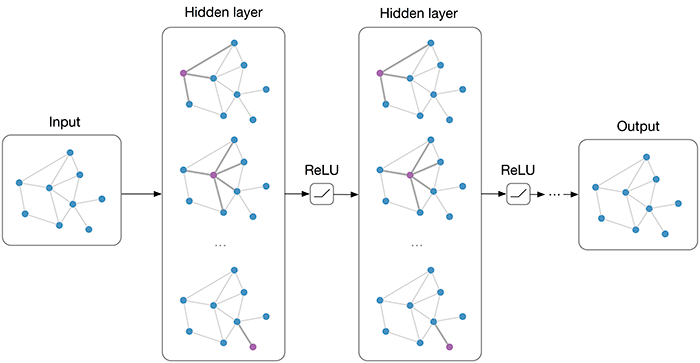

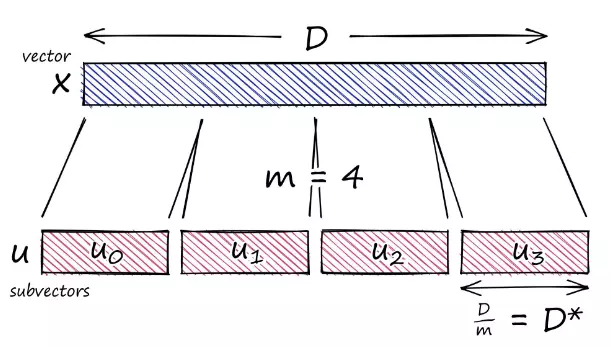

Mem0 sẽ tập trung vào vấn đề chính là phần Long Term Memory trong hệ thống AI Agents. Thì trước tiên...

1. Spec Driven Development (SDD) là gì? Mục tiêu và lợi ích trong thực tế

Spec Driven Development (Phát triển hướng Đặc tả) là một phương pháp phát triển phần mềm đặt đặc tả (specification) lên hàng đầu. Thay vì viết mã ngay, nhóm phát triển đầu tiên soạn thảo một tài liệu đặc tả chi tiết mô tả cái gì cần xây dựng và tại sao, rồi mới quyết định như thế nào để thực hiện. Đặc tả này đóng vai ...

Lời mở đầu Chắc hẳn bạn đã từng ao ước có thể "thổi hồn" vào những bức ảnh tĩnh, biến chúng trở nên sống động và biết nói? Hay bạn đang tìm kiếm một công cụ đột phá để tạo ra những video độc đáo, thu hút cho các dự án của mình mà không cần đến kỹ năng quay dựng phức tạp? Nếu câu trả lời là có, thì bạn đã tìm đến đúng nơi rồi đấy

Trong thế giới kỹ thuật số không ngừng phát triển, trí tuệ nhân t...

Lời mở đầu Xin chào mọi người, lại là tôi đây. Trong thế giới AI ngày nay, một trong những thách thức lớn nhất không chỉ là xây dựng những mô hình mạnh mẽ, mà còn là làm thế nào để mô hình có thể giao tiếp, hiểu và phối hợp hiệu quả với các công cụ, dữ liệu, hay dịch vụ bên ngoài. Đây chính là lý do Model Context Protocol (MCP) ra đời.

Trong bài viết này, chúng ta sẽ cùng nhau đi sâu vào khám ...

Sơ đồ hoạt động của hệ thống: Dưới đây là sơ đồ hoạt động của hệ thống digital human:

Nhìn vào kiến trúc tổng thể, ta thấy rằng để hiển thị Digital Humans một cách sống động, chúng ta cần đồng bộ hóa giữa hình ảnh video và âm thanh, và đẩy cả hai vào một luồng stream duy nhất. Nhưng đó mới chỉ là một nửa câu chuyện. Trải nghiệm sẽ chẳng thể trọn vẹn nếu người dùng không thể tương tác trực tiếp...

Mở đầu. Hiện tại đang là 31/5🫠, mình về quê, chưa biết làm gì cả, thôi thì viết thêm một bài nữa kết thúc tháng 5 nào 😉.

Thì 3 bài trước đó mình đã viết loanh quanh về khả năng của LLM. Vậy thì chính xác model LLM đã làm gì, điều gì khiến nó trở lên lên thông minh như vậy ? Tại sao nó làm được nhưng điều tưởng chừng chỉ có con người mới làm được ? Liệu LLM đã thật sự suy luận hay AGI đang đến ...

Introduction Trong quá trình triển khai mô hình machine learning/deep learning lên sản phẩm thực tế, những thách thức lớn không chỉ nằm ở việc huấn luyện mô hình, mà còn nằm ở khâu triển khai (serving) sao cho nhanh chóng, ổn định và dễ bảo trì. Trước kia, rất nhiều người bắt đầu bằng cách tự viết Flask hoặc FastAPI để dựng API cho mô hình, kết hợp với Docker nhằm mục đích đóng gói. Nhưng khi s...

Mở đầu. Ở phần 1 mình đã nói khá nhiều về các khái niệm của các dạng LLm, cách hoạt động và hình thành, đồng thời nói về các cách tạo nên reasoning của LLMs và phần 2 thì mình có nói đến một paper nói rằng :

- RLVR chưa phải là một cách đột phá trong việc khiến base model tìm kiếm ra được những reasoning path vượt ra khỏi ngưỡng kiến thức của mô hình base. và việc tạo ra dataset gồm nhiều reas...

Overview Trong các bài viết trước đây, mình đã lần lượt giới thiệu đến các bạn hai công cụ cho quá trình tăng tốc xử lý dữ liệu và triển khai mô hình Deep Learning là NVIDIA DALI và Triton Inference Server. Mình xin phép nhắc lại thông tin cơ bản một chút.

NVIDIA DALI Với NVIDIA DALI (Data Loading Library), mình đã trình bày các khái niệm nền tảng về thư viện này với mục đích tối ưu hóa khâu t...

Overview Trong bài viết lần trước , mình đã đề cập đến những thông tin cơ bản nhất của NVIDIA DALI, bao gồm khái niệm tổng quan về thư viện này, mục đích sử dụng cũng như những ưu điểm nổi bật mà nó mang lại trong quá trình xử lý dữ liệu hình ảnh và video cho các mô hình học sâu. Bên cạnh đó, mình cũng đã giới thiệu sơ lược về cách tích hợp DALI vào pipeline huấn luyện, giúp tăng tốc độ tiền xử...

Introduction Khi huấn luyện các mô hình deep learning, chúng ta thường dành nhiều sự quan tâm đến kiến trúc mô hình, lựa chọn loss function phù hợp, optimizer, tuning hyperparameters,... Nhưng có một thứ cũng khá quan trọng mà ta thường không quan tâm nhiều đó là hiệu suất xử lý dữ liệu đầu vào.

Multi-stage data preprocessing pipelines bao gồm loading, decoding hay augmentations là bước không ...

Giới thiệu

Nói chung LangGraph là một thư viện được xây dựng dựa trên LLM và LangChain, giúp ta đơn giản hóa việc xây dựng các Agent tự động hóa các tác vụ trong thế giới thực.

Vì sao cần LangGraph?

Ta thấy rằng LangChain cho phép chúng ta xây dựng code bằng LCEL( LangChain Expression Language ). Về cơ bản LCEL xây dựng các Chain, để dễ hiểu ta hãy xét một Chain cơ bản sau:

Có thể thấy, một...

Introduction Bối cảnh Human-in-the-loop (HITL) trong LangGraph thật ra khá là đơn giản, chính cái tên dường như đã giúp bạn hình dung phần nào về định nghĩa của nó. Khi chúng ta cần sự tích hợp của con người vào quá trình xử lý của mô hình AI, hay nói cách khác là ta đang cố gắng kiểm soát chúng, hiệu chỉnh và xác nhận kết quả. Điều này khá quan trọng trong các hệ thống sử dụng LangGraph, đặc b...

Dùng LLM để “chém gió” thì ổn, nhưng khi chuyển sang các lĩnh vực chuyên sâu như y khoa, tài chính hay nghiên cứu khoa học, model vẫn thường trả lời thiếu chính xác hoặc thậm chí sai lệch. Nguyên nhân chính là dù đã được pre‑train trên khối lượng dữ liệu khổng lồ, mô hình vẫn chưa nắm vững những mối liên hệ chuyên môn phức tạp. Kết quả là hallucination – tức chém bừa không có căn cứ – vẫn diễn ...

Chào các bạn, những chiến binh đang ngày đêm "vật lộn" với dữ liệu! Chắc hẳn không ít lần chúng ta tự hỏi: Dữ liệu thì ở tứ xứ, từ cái database SQL cổ lỗ sĩ trong công ty, file CSV vứt trên Blob Storage, cho đến mấy cái API "sang chảnh". Làm thế nào để "gom" tụi nó lại, "xào nấu" rồi "dọn ra mâm" cho sếp xem báo cáo, hay cho mấy em AI/ML "măm măm"? Đấy, Azure Data Factory (gọi tắt là ADF cho th...

Nếu bạn thấy hay, hãy upvote và bookmark cho mình nhé, chỉ đơn giản là động lực nhỏ để mình ngồi đọc và chia sẻ cùng mọi người những điều hay ho khi ngồi nghịch những tech mới thôi kk. Đây là một paper khá hay, nếu không đọc bài của mình thì cũng nên đọc qua thử paper nhé 😉, đâu mất gì đâu. Mở đầu. Ở bài viết phần 1 trước đó thì mình đã từng nói qua các khái niệm về khả năng của LLm như Reason...

Mở đầu Nối tiếp bài viết trước, chúng ta sẽ cùng trao đổi 2 keywords tiếp theo liên quan đến MCP: Sampling và Roots. Let's do it

Sampling - Khi Server "nhờ" LLM sáng tạo thông qua Client Trong Model Context Protocol (MCP), Sampling là một tính năng mạnh mẽ cho phép các server yêu cầu các LLM tạo ra "completions" (ví dụ: hoàn thiện một đoạn văn bản, trả lời câu hỏi, tóm tắt nội dung) thông qua ...

Chào anh em, hôm nay mình sẽ đi sâu vào Memory API mới của LlamaIndex – một bước tiến lớn giúp agent AI có khả năng ghi nhớ và truy xuất thông tin cực kỳ linh hoạt, gần giống như trí nhớ con người. Đặc biệt, mình sẽ phân tích chi tiết từng loại Memory Block (plugin) để anh em hiểu rõ cách tận dụng tối đa sức mạnh của từng loại.

Tổng quan Memory API: Hai lớp bộ nhớ, nhiều plugin mạnh mẽ Memory ...